hadoop mapreduce java 单词统计三个实现方法_hadoop数据分块单词被分开怎么统计-程序员宅基地

技术标签: mapreduce hadoop mapreduce 单词统计 大数据

hadoop MapReduce框架可以让你的应用在集群中:可靠地、容错地、并行、处理TB级别的数据。

本实例通过idea运行java本地代码,实现统计单词计数。

hadoop集群搭建见 hadoop基于zookeper自动高可用搭建。这里就不在重复赘述。

1 统计文件准备

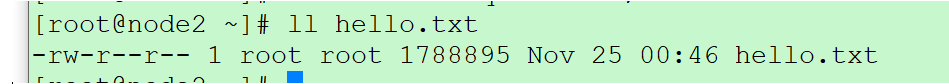

1.1 创建需要统计单词的文件

任意选择一条服务器,创建包含hello world number hello.txt文件

for i in `seq 100000`;do echo hello world $i >hello.txt ;done;

1.2 上传到hdfs文件系统上

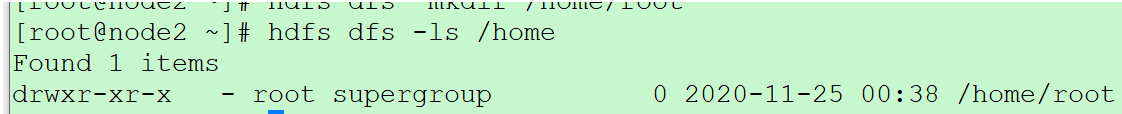

创建目录 /home/root

hdfs dfs -mkdir /home

hdfs dfs -mkdir /home/root

查看是否创建成功

hdfs dfs -ls /home

上传文件到hdfs服务器上

设置块大小为1MB

hdfs dfs -D dfs.blocksize=1048576 -put hello.txt /home/root

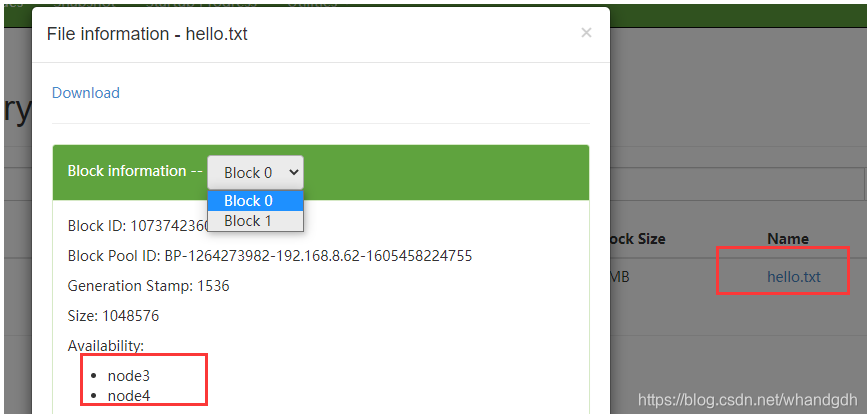

通过前台页面:node2:50070 可以看到上传文件被分为2个块 ,存放在node3和node4上

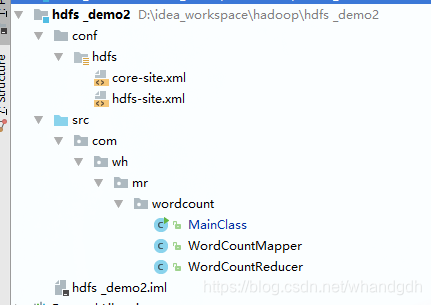

2 创建java项目

结构如下:

2.1 配置文件

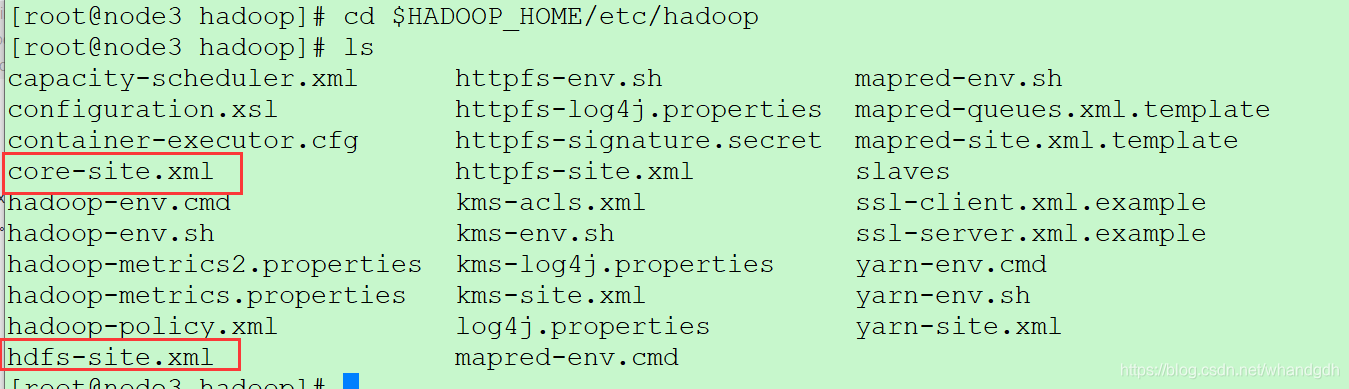

conf目录下配置文件core-site.xml和hdfs-site.xml文件来在hadoop集群服务器上,路径为HADOOP_HOME/etc/hadoop。将此文件拷贝到本地java工程即可

cd $HADOOP_HOME/etc/hadoop

2.2 java代码

2.2.1 WordCountMapper 类

WordCountMapper 类需要重写map方法,代码如下:

ublic class WordCountMapper extends Mapper<LongWritable,Text,Text,IntWritable> {

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// key value

// <0, "hello world 1">

// "hello bjsxt 1" 输出到reduce

String line=value.toString();

String [] words=line.split(" ");

for (int i = 0; i < words.length-1; i++) {

//排除最后一位数字

context.write(new Text(words[i]),new IntWritable(1));

}

}

}

2.2.2WordCountReducer 类

WordCountReducer 类需要重写reduce方法。代码如下

public class WordCountReducer extends Reducer<Text,IntWritable,Text,IntWritable> {

// <"hello", 1>

// <"hello", 1>

// key "hello", {

1,1,1,1,1,1,1,1,1,1,1,1} reducer 处理前结果

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum=0;

for (IntWritable value : values) {

sum+=value.get();

}

// 输出结果为 <hello ,120>

context.write(key,new IntWritable(sum));

}

}

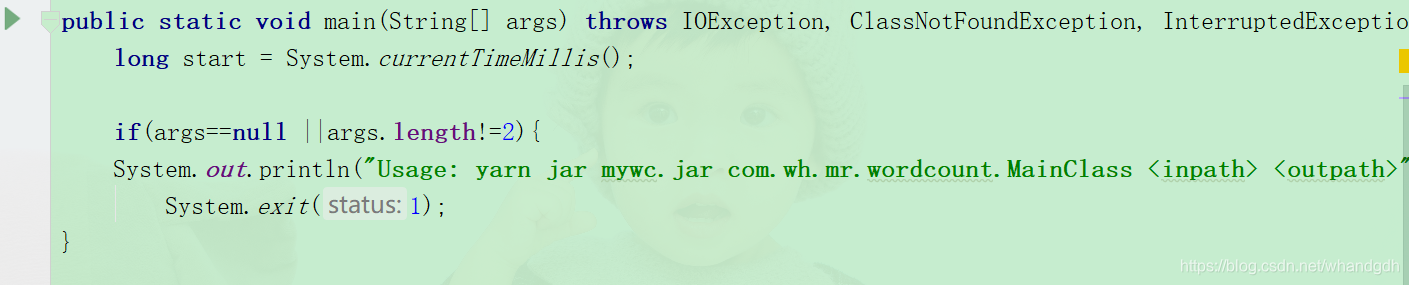

2.2.3 MainClass 类

MainClass类为本地运行类,代码如下:

//客户端运行

public class MainClass {

// yarn jar mywc.jar com.bjsxt.mr.wordcount.MainClass /input /output

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

long start = System.currentTimeMillis();

if(args==null ||args.length!=2){

System.out.println("Usage: yarn jar mywc.jar com.wh.mr.wordcount.MainClass <inpath> <outpath>");

System.exit(1);

}

Configuration conf=new Configuration(true);

// 本地运行

conf.set("mapreduce.framework.name","local");

// 创建mapreduce作业Job对象

Job job=Job.getInstance(conf);

// 设置作业的名称

job.setJobName("单次计数");

// 设置作业的主入口类

job.setJarByClass(MainClass.class);

// 设置输入文件路径,该方法可以调用多次,用于设置多个输入文件路径

FileInputFormat.addInputPath(job,new Path(args[0]));

// 设置输出文件路径

FileOutputFormat.setOutputPath(job,new Path(args[1]));

// 设置mapper类

job.setMapperClass(WordCountMapper.class);

// 设置reducer类

job.setReducerClass(WordCountReducer.class);

// 设置mapper输出key的类型,用于排序

job.setMapOutputKeyClass(Text.class);

// 设置mapper输出value的类型

job.setMapOutputValueClass(IntWritable.class);

// 提交作业到集群运行,并等待程序在集群中运行结束

job.waitForCompletion(true);

long end = System.currentTimeMillis();

long cost = end - start;

System.out.println("耗时:"+cost);

}

}

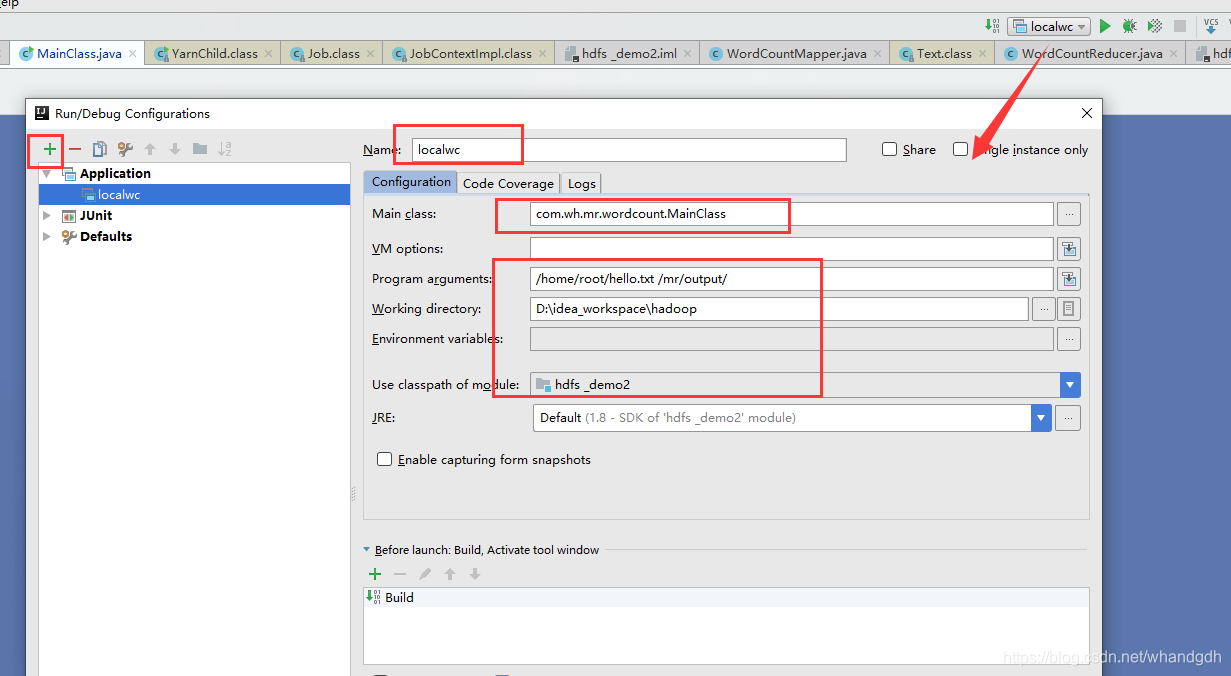

3 参数设置

需要从main方法传入需要处理的文件以及输出结果目录,设置如下图所示

需要注意的是 program arguments参数设置需要处理的文件以及处理结果路径。结果处理存放路径不能是存在的,不然程序会抛异常

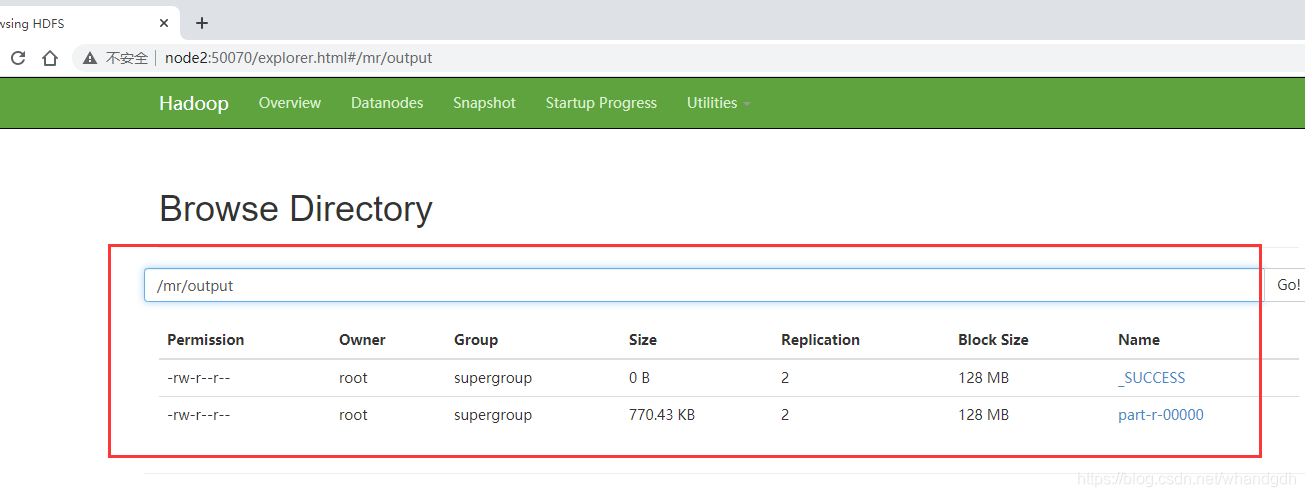

4 运行结果

运行程序以后,通过页面node2:50070进入文件管理可以看到执行结果

存放到/mr/output目录下

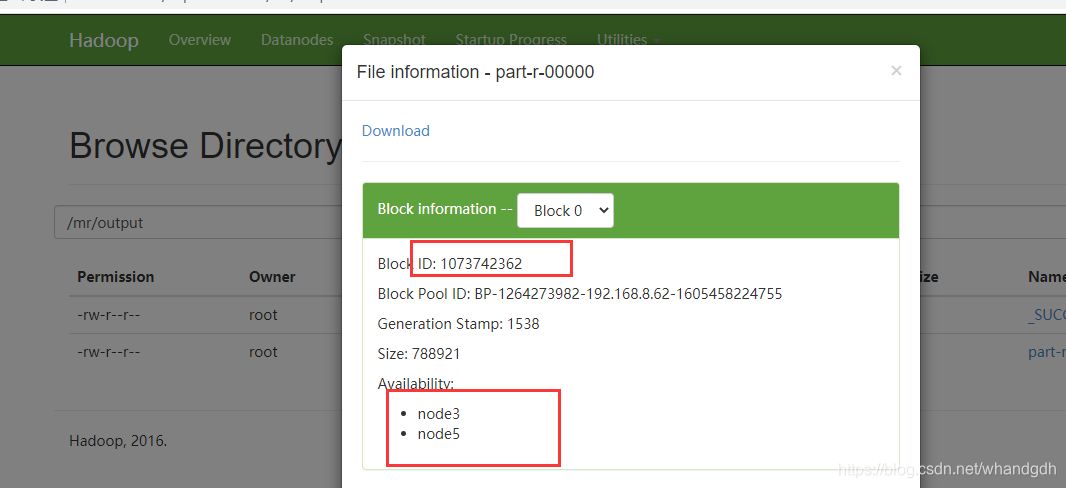

执行结果写入到 part-r-00000文件中,该文件块id为1073742362。

写入到node3和node5上

node3和node5任意选一台,本实例选择node5.

进入数据存放目录。

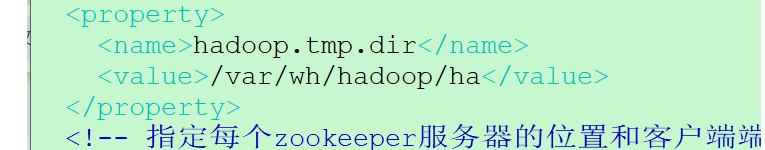

core-site.xml(cd $HADOOP_HOME/etc/hadoop)这个配置文件

/var/wh/hadoop/ha

进入如下路径

var/wh/hadoop/ha/dfs/data/current/BP-1264273982-192.168.8.62-1605458224755/current/finalized/subdir0

进入后有三个文件

查找执行结果文件存放目录

find . -name '*1073742362*'

看到 文件存放在 subdir2下

vim blk_1073742362

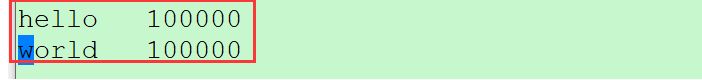

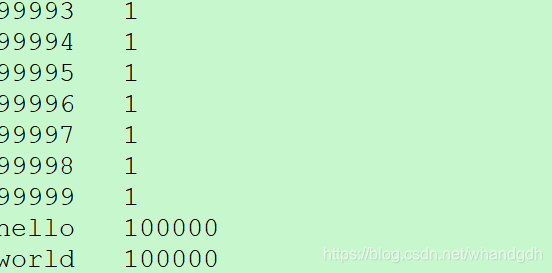

看到 统计hello 和world 个数都为10w个

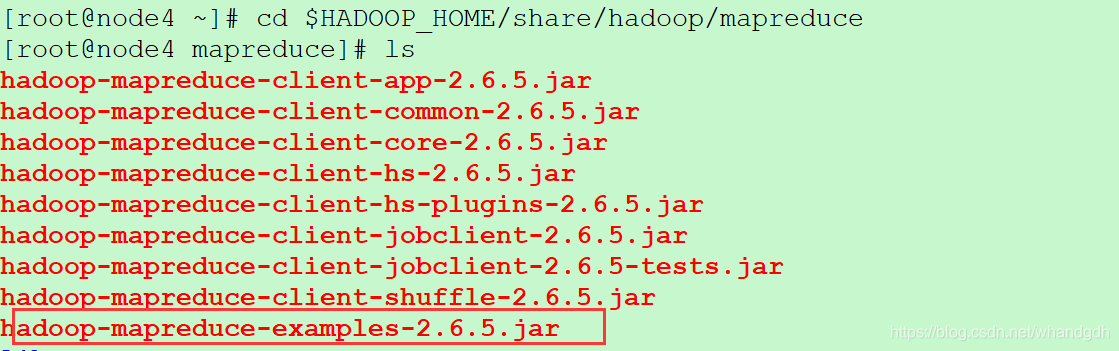

5 服务器运行本地单词计数程序

hadoop自带有单词统计程序,在 $HADOOP_HOME/share/hadoop/mapreduce目录下

cd $HADOOP_HOME/share/hadoop/mapreduce

ls

在这里插入图片描述

然后执行

hadoop jar hadoop-mapreduce-examples-2.6.5.jar wordcount /home/root/hello.txt /mr/wordcount/output

*ouput:是hdfs中不存在的目录,mr程序运行的结果会输出到该目录

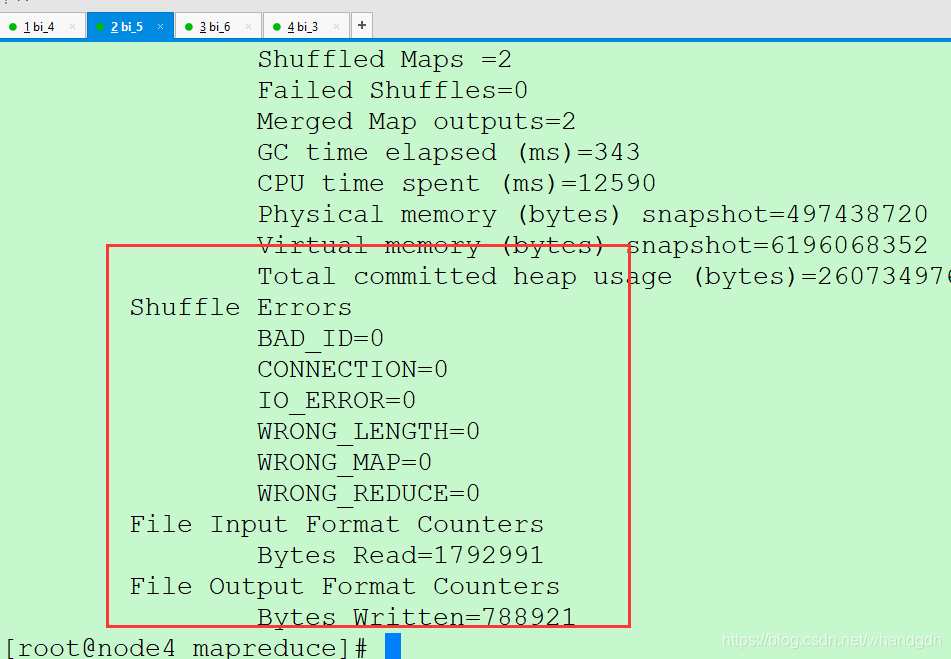

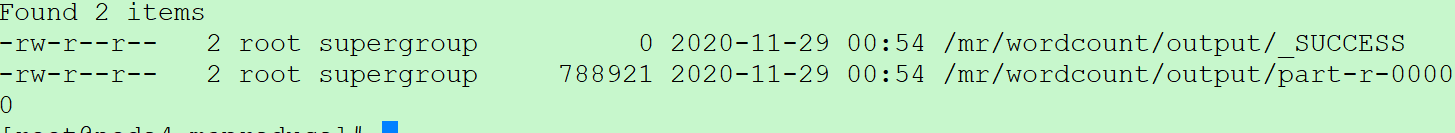

执行结果

hdfs dfs -ls /mr/wordcount/output

结果存放在part-r-00000文件上

再通过如下命令查看结果

hdfs dfs -cat /mr/wordcount/output/part-r-00000

6 打包本地java代码到服务器执行

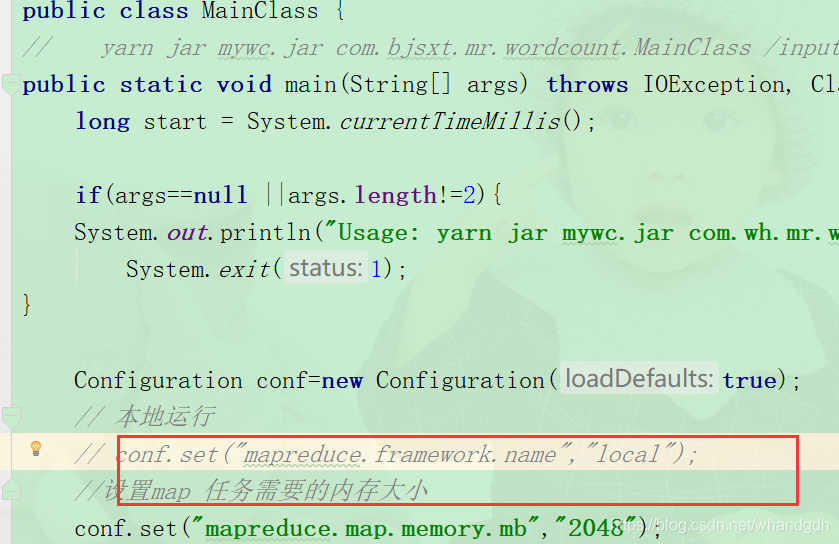

还可以将本地的java代码打包到服务器执行,只是需要将mainclass文件中设置本地运行代码注释掉

conf.set("mapreduce.framework.name","local");

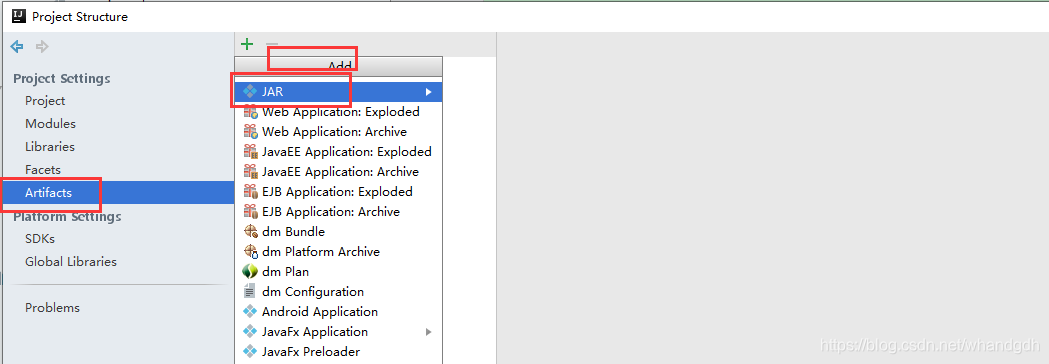

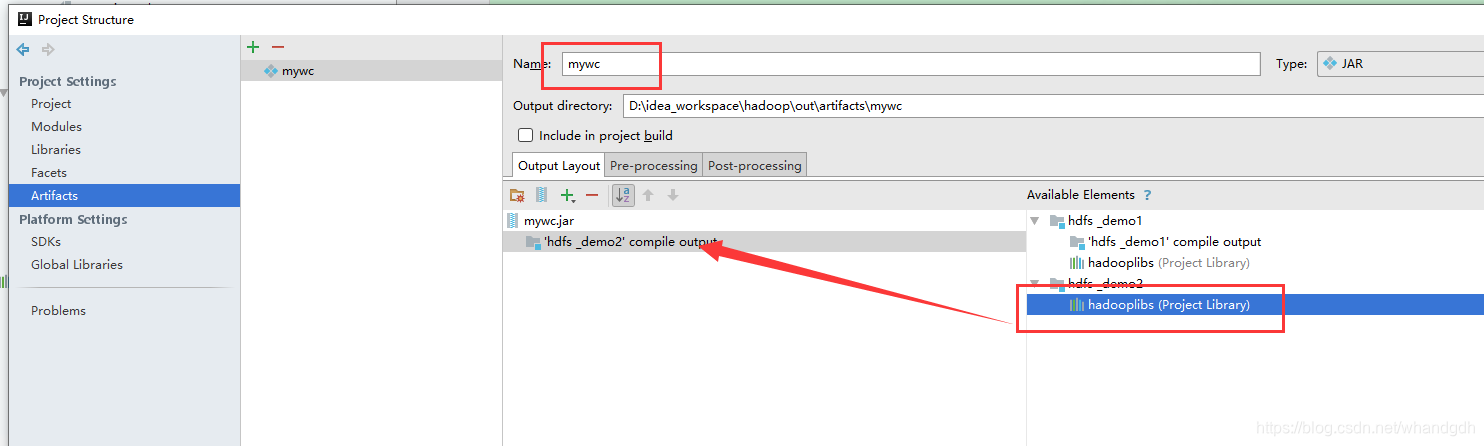

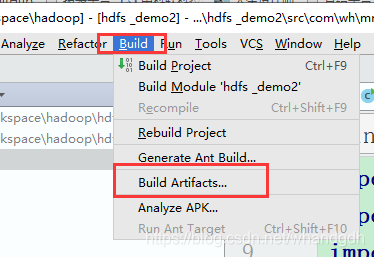

打包页面如下

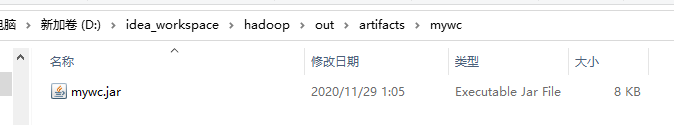

进入到打包目录找到包文件

D:\idea_workspace\hadoop\out\artifacts\mywc

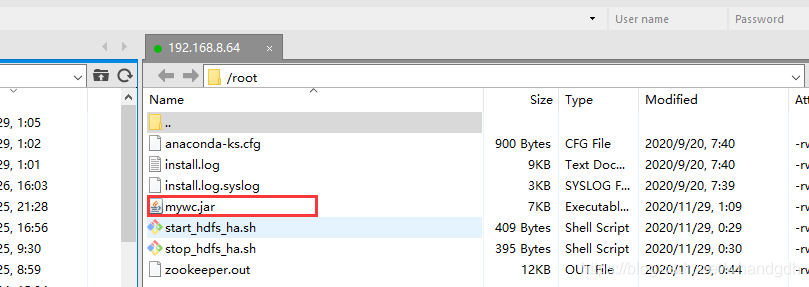

上传代码到服务器上,

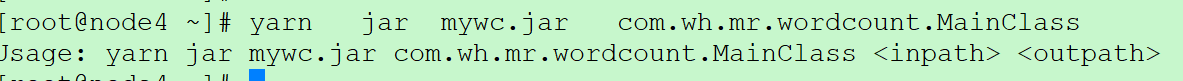

如果没有传参数运行

yarn jar mywc.jar com.wh.mr.wordcount.MainClass

可以看到这里运行结果按照java代码中进行退出。

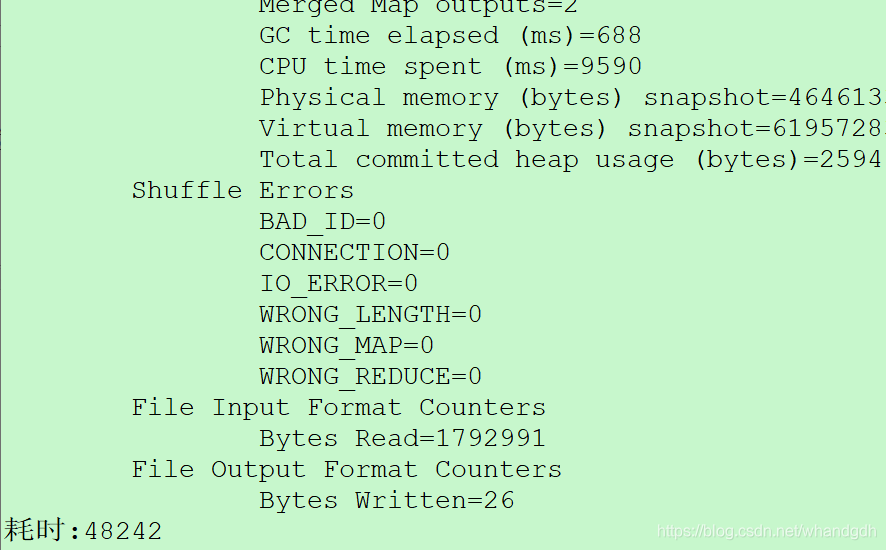

yarn jar mywc.jar com.wh.mr.wordcount.MainClass /home/root/hello.txt /mr/wordcount/output2

运行结果

智能推荐

18个顶级人工智能平台-程序员宅基地

文章浏览阅读1w次,点赞2次,收藏27次。来源:机器人小妹 很多时候企业拥有重复,乏味且困难的工作流程,这些流程往往会减慢生产速度并增加运营成本。为了降低生产成本,企业别无选择,只能自动化某些功能以降低生产成本。 通过数字化..._人工智能平台

electron热加载_electron-reloader-程序员宅基地

文章浏览阅读2.2k次。热加载能够在每次保存修改的代码后自动刷新 electron 应用界面,而不必每次去手动操作重新运行,这极大的提升了开发效率。安装 electron 热加载插件热加载虽然很方便,但是不是每个 electron 项目必须的,所以想要舒服的开发 electron 就只能给 electron 项目单独的安装热加载插件[electron-reloader]:// 在项目的根目录下安装 electron-reloader,国内建议使用 cnpm 代替 npmnpm install electron-relo._electron-reloader

android 11.0 去掉recovery模式UI页面的选项_android recovery 删除 部分菜单-程序员宅基地

文章浏览阅读942次。在11.0 进行定制化开发,会根据需要去掉recovery模式的一些选项 就是在device.cpp去掉一些选项就可以了。_android recovery 删除 部分菜单

mnn linux编译_mnn 编译linux-程序员宅基地

文章浏览阅读3.7k次。https://www.yuque.com/mnn/cn/cvrt_linux_mac基础依赖这些依赖是无关编译选项的基础编译依赖• cmake(3.10 以上)• protobuf (3.0 以上)• 指protobuf库以及protobuf编译器。版本号使用 protoc --version 打印出来。• 在某些Linux发行版上这两个包是分开发布的,需要手动安装• Ubuntu需要分别安装 libprotobuf-dev 以及 protobuf-compiler 两个包•..._mnn 编译linux

利用CSS3制作淡入淡出动画效果_css3入场效果淡入淡出-程序员宅基地

文章浏览阅读1.8k次。CSS3新增动画属性“@-webkit-keyframes”,从字面就可以看出其含义——关键帧,这与Flash中的含义一致。利用CSS3制作动画效果其原理与Flash一样,我们需要定义关键帧处的状态效果,由CSS3来驱动产生动画效果。下面讲解一下如何利用CSS3制作淡入淡出的动画效果。具体实例可参考刚进入本站时的淡入效果。1. 定义动画,名称为fadeIn@-webkit-keyf_css3入场效果淡入淡出

计算机软件又必须包括什么,计算机系统应包括硬件和软件两个子系统,硬件和软件又必须依次分别包括______?...-程序员宅基地

文章浏览阅读2.8k次。计算机系统应包括硬件和软件两个子系统,硬件和软件又必须依次分别包括中央处理器和系统软件。按人的要求接收和存储信息,自动进行数据处理和计算,并输出结果信息的机器系统。计算机是脑力的延伸和扩充,是近代科学的重大成就之一。计算机系统由硬件(子)系统和软件(子)系统组成。前者是借助电、磁、光、机械等原理构成的各种物理部件的有机组合,是系统赖以工作的实体。后者是各种程序和文件,用于指挥全系统按指定的要求进行..._计算机系统包括硬件系统和软件系统 软件又必须包括

随便推点

进程调度(一)——FIFO算法_进程调度fifo算法代码-程序员宅基地

文章浏览阅读7.9k次,点赞3次,收藏22次。一 定义这是最早出现的置换算法。该算法总是淘汰最先进入内存的页面,即选择在内存中驻留时间最久的页面予以淘汰。该算法实现简单,只需把一个进程已调入内存的页面,按先后次序链接成一个队列,并设置一个指针,称为替换指针,使它总是指向最老的页面。但该算法与进程实际运行的规律不相适应,因为在进程中,有些页面经常被访问,比如,含有全局变量、常用函数、例程等的页面,FIFO 算法并不能保证这些页面不被淘汰。这里,我_进程调度fifo算法代码

mysql rownum写法_mysql应用之类似oracle rownum写法-程序员宅基地

文章浏览阅读133次。rownum是oracle才有的写法,rownum在oracle中可以用于取第一条数据,或者批量写数据时限定批量写的数量等mysql取第一条数据写法SELECT * FROM t order by id LIMIT 1;oracle取第一条数据写法SELECT * FROM t where rownum =1 order by id;ok,上面是mysql和oracle取第一条数据的写法对比,不过..._mysql 替换@rownum的写法

eclipse安装教程_ecjelm-程序员宅基地

文章浏览阅读790次,点赞3次,收藏4次。官网下载下载链接:http://www.eclipse.org/downloads/点击Download下载完成后双击运行我选择第2个,看自己需要(我选择企业级应用,如果只是单纯学习java选第一个就行)进入下一步后选择jre和安装路径修改jvm/jre的时候也可以选择本地的(点后面的文件夹进去),但是我们没有11版本的,所以还是用他的吧选择接受安装中安装过程中如果有其他界面弹出就点accept就行..._ecjelm

Linux常用网络命令_ifconfig 删除vlan-程序员宅基地

文章浏览阅读245次。原文链接:https://linux.cn/article-7801-1.htmlifconfigping <IP地址>:发送ICMP echo消息到某个主机traceroute <IP地址>:用于跟踪IP包的路由路由:netstat -r: 打印路由表route add :添加静态路由路径routed:控制动态路由的BSD守护程序。运行RIP路由协议gat..._ifconfig 删除vlan

redux_redux redis-程序员宅基地

文章浏览阅读224次。reduxredux里要求把数据都放在公共的存储区域叫store里面,组件中尽量少放数据,假如绿色的组件要给很多灰色的组件传值,绿色的组件只需要改变store里面对应的数据就行了,接着灰色的组件会自动感知到store里的数据发生了改变,store只要有变化,灰色的组件就会自动从store里重新取数据,这样绿色组件的数据就很方便的传到其它灰色组件里了。redux就是把公用的数据放在公共的区域去存..._redux redis

linux 解压zip大文件(解决乱码问题)_linux 7za解压中文乱码-程序员宅基地

文章浏览阅读2.2k次,点赞3次,收藏6次。unzip版本不支持4G以上的压缩包所以要使用p7zip:Linux一个高压缩率软件wget http://sourceforge.net/projects/p7zip/files/p7zip/9.20.1/p7zip_9.20.1_src_all.tar.bz2tar jxvf p7zip_9.20.1_src_all.tar.bz2cd p7zip_9.20.1make && make install 如果安装失败,看一下报错是不是因为没有下载gcc 和 gcc ++(p7_linux 7za解压中文乱码